Les chercheurs d’IBM Security Trusteer ont découvert récemment une campagne d’infection utilisant une nouvelle variante du cheval de Troie Tinba visant les clients des banques Européennes. Cette dernière version possède de nouvelles fonctions qui améliorent significativement l’efficacité et la résilience de ce logiciel malveillant.

Petit et Gratuit

Tinba est une abréviation de “tiny banker”, découvert en 2012, était le plus petit cheval de Troie bancaire en circulation par sa taille.

La destinée de Tinba pris un tournant intéressant quand son code source a été rendu public en juillet 2011, probablement à la suite d’une dispute entre cybercriminels rivaux. Depuis cette fuite, plusieurs bandes ont été en mesure de retravailler ce code malveillant fonctionnel et gratuit.

En septembre de l’année dernière, le blog Security Intelligence faisait part de plusieurs campagnes utilisant des variations de Tinba tout autour de la planète avec souvent des améliorations dues à la prolifération du code source original.

Le dernier tour d’Europe

En mai 2015, les chercheurs d’IBM Security Trusteer ont détecté une campagne d’infection Tinba visant la Pologne, l’Italie, la Hollande et l’Allemagne. Presque la moitié des incidents étaient situés en Pologne, en fait 45% des événements tracés étaient issus de ce pays. L’Italie était second, loin derrière avec 21%.

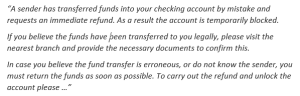

Vol d’identifiants et faux messages

Quand Tinba infecte un ordinateur et que l’utilisateur cherche à se connecter à une banque ciblée, Tinba lance ses « webinjects ». En fonction de la banque ciblée, les victimes reçoivent de faux messages et formulaires demandant des informations personnelles, mot de passe ou demandes de transfert de fonds. La notification cherche même parfois à convaincre que de l’argent a été ajouté accidentellement au compte de la victime et doit être rendu immédiatement.

Ci-dessous un exemple en anglais

White Paper: Winning the War on Cybercrime

Les mécanismes de protection de Tinba

L’auteur de cette variation de Tinba, lutte contre la recherche des chevaux de Troie et fait tout pour maintenir la résilience, éviter un détournement possible. Il a donc prévu plusieurs mécanismes de protection pour s’assurer que le botnet reste intact. Voici une liste non-exhaustive de ces mécanismes :

- Signature par clés publiques pour s’assurer que les commandes du bot et les mises à jour proviennent bien du botmaster autorisé.

- Authentification par le bot du serveur faisant la mise à jour avant d’autoriser une nouvelle configuration.

- Une couche chiffrée dépendant de chaque machine pour empêcher les chercheurs en sécurité de mystifier les bots.

- Les Bots communiquent aves des URLs codées en dur, et reviennent à des URLs fabriqués par DGA (Domain-Generation Algorithm) quand besoin est.

La globalisation des menaces

Cette dernière campagne Tinba n’est qu’une menace parmi beaucoup d’autres qui visent l’Europe après avoir visée les Banques Américaines. Les cybercriminels organisés comme le Dyre ont réussi à franchir les barrières linguistiques et adaptent leurs tactiques aux banques locales. Cette tendance est un défi pour les banques n’ayant pas encore renforcé leurs défenses. Ce délai est aussi une chance puisqu’elles peuvent s’appuyer sur ceux qui ont déjà combattu ce logiciel malveillant.

Merci à Ori BACH auteur du billet d’origine en Anglais